أفضل 5 أدوات لتحميل موقع ويب كامل على كمبيوترك لتصفحه دون إنترنت

هل تبحث عن طريقة لتحميل موقع ويب كامل؟ أنت في المكان الصحيح لمعرفة قائمة أفضل 5 أدوات لتحميل موقع ويب كامل على كمبيوترك لتصفحه دون إنترنت لعام 2023.

شبكات الوايفاي منتشرة في كل مكان هذه الأيام، لكن في بعض الأحيان لا يمكنك الاتصال بالإنترنت. لتجنب نفاد الموارد المخصصة، قد يكون لديك موقع ويب تريد تخزينه للوصول إليه دون اتصال بالإنترنت – ربما للبحث أو الترفيه.

يعد حفظ صفحات الويب الفردية للقراءة في وضع عدم الاتصال أمرًا سهلاً للغاية، ولكن ماذا لو كنت تريد تحميل موقع ويب بالكامل؟ لا تقلق. إنه أسهل مما تعتقد.

فيما يلي عدد من الأدوات الرائعة التي يمكنك استخدامها لتحميل موقع ويب كامل وقراءة المحتوى في وضع عدم الاتصال دون أي متاعب.

أفضل 5 أدوات لتحميل موقع ويب كامل لتصفحه دون إنترنت

1- برنامج Teleport Pro

تم إصدار أحدث إصدار من هذا التطبيق في عام 2015 ويعمل بنفس الجودة التي كان يعمل بها في ذلك الوقت.

لا يقوم هذا التطبيق بتحميل موقع الويب بالكامل فحسب، بل يتضمن أيضًا العديد من الميزات والتعقيدات الأخرى. على سبيل المثال، بعد تحميل التطبيق وتثبيته، توفر القائمة الرئيسية للتطبيق الخيارات التالية للاختيار:

- قم بعمل نسخة من موقع الويب على قرصك الصلب.

- استنساخ موقع ويب بأكمله في هيكل الدليل الخاص به.

- ابحث في موقع ويب عن نوع ملف معين.

- ابحث في مواقع الويب عن كلمات رئيسية محددة.

- عرض جميع المواقع ذات الصلة من الموقع المركزي.

هذه والعديد من الميزات المماثلة الأخرى تجعل هذا التطبيق خيارًا مفيدًا كمجموعة أدوات. كان الجانب السلبي الوحيد الذي وجدناه هو قيود الإصدار المجاني. يسمح لك الإصدار غير المسجل بنسخ 500 صفحة فقط في مشروع واحد. بالإضافة إلى ذلك، يمكنك استخدامه حتى 40 مرة قبل شراء الإصدار المتميز.

تحميل: Teleport Pro لنظام التشغيل ويندوز (إصدار تجريبي مجاني، إصدار مدفوع متاح)

شرح طريقة تجريف موقع الويب وإستخراج أي بيانات ترغب بها بإستخدام التطبيقات

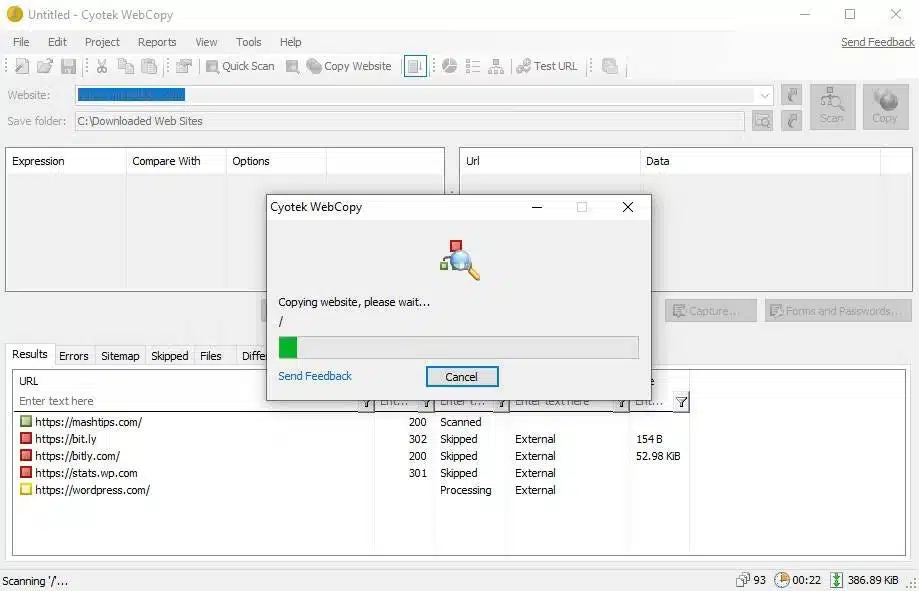

2- برنامج WebCopy لتحميل موقع ويب كامل

يأخذ WebCopy الخاص بـ Cyotek عناوين URL الخاصة بالمواقع الإلكترونية ويقوم بمسح الروابط والصفحات والوسائط. بمجرد العثور على الصفحة، ستبحث بشكل متكرر عن روابط وصفحات ووسائط إضافية حتى يتم العثور على موقع الويب بالكامل. يمكنك بعد ذلك استخدام خيارات التكوين لاختيار الأجزاء المراد تحميلها في وضع عدم الاتصال.

ميزة مثيرة للاهتمام في WebCopy هي القدرة على إعداد مشاريع متعددة، لكل منها إعداداته وتكويناته الخاصة. هذا يجعل من السهل إعادة تحميل العديد من مواقع الويب في أي وقت. نفس الشيء في كل مرة.

استخدم خطة منظمة، حيث يمكنك نسخ العديد من مواقع الويب في مشروع واحد (على سبيل المثال، مشروع “تقني” لنسخ مواقع الويب التقنية).

طريقة تحميل موقع ويب كامل باستخدام WebCopy

باستخدام هذا البرنامج، من السهل جدًا حفظ موقع ويب بأكمله. إليك الطريقة:

- قم بتثبيت التطبيق وتشغيله.

- ثم أنشئ مشروعًا جديدًا بالانتقال إلى ملف -> جديد.

- أدخل عنوان URL في حقل موقع الويب.

- قم بتغيير حقل حفظ المجلد إلى المكان الذي تريد حفظ موقع الويب الخاص بك فيه.

- يمكنك تحريره في Project -> Rules… (اقرأ المزيد عن قواعد WebCopy هنا).

- ثم احفظ المشروع بالانتقال إلى ملف -> حفظ باسم…

- انقر فوق “نسخ” على شريط الأدوات لبدء العملية.

بمجرد اكتمال النسخ، يمكنك استخدام علامة التبويب النتائج للتحقق من حالة الصفحات الفردية وملفات الوسائط. تعرض علامة التبويب “الأخطاء” أية مشكلات قد تكون حدثت، وتعرض علامة التبويب “تخطي” الملفات التي لم يتم تحميلها. ولكن الأهم من ذلك هو خريطة الموقع “Sitemap” التي تعرض بنية الدليل الكاملة لمواقع الويب التي عثر عليها WebCopy.

لعرض موقع الويب في وضع عدم الاتصال، افتح File Explorer وانتقل إلى مجلد التخزين الذي تم تعيينه مسبقًا. ابدأ التصفح بفتح index.html (وربما index.htm) في المتصفح الذي تختاره. كما ترى، يختلف هذا كثيرًا عن حفظ صفحات الويب الفردية من خلال أحد التطبيقات، وهو أمر شائع هذه الأيام.

تحميل: WebCopy لنظام التشغيل ويندوز (مجانًا)

شرح تقنية تجريف الويب – الزحف- للحصول على بيانات أشهر المواقع؟

3- برنامج HTTrack لتحميل موقع ويب كامل

HTTrack معروف بشكل أفضل من WebCopy، وربما يكون أفضل لأنه مفتوح المصدر ومتاح للأنظمة الأساسية بخلاف ويندوز. الواجهة مزدحمة قليلاً وتترك الكثير مما هو مرغوب فيه. لكن لا تتردد في استخدامه لأنه يعمل بشكل جيد للغاية.

على غرار WebCopy، يمكنك نسخ مواقع ويب متعددة وتنظيمها باستخدام نهج قائم على المشروع. كما يمكنك إيقاف التحميلات مؤقتًا واستئنافها وإعادة تحميل الملفات القديمة والجديدة لتحديث مواقع الويب المنسوخة.

طريقة تحميل موقع ويب كامل باستخدام HTTrack

لإتاحة موقع الويب المفضل لديك بالكامل في وضع عدم الاتصال، اتبع الخطوات التالية:

- قم بتثبيت التطبيق وتشغيله.

- انقر فوق “التالي” لبدء إنشاء مشروع جديد.

- ثم أدخل اسمًا وفئة ومسارًا لمشروعك، ثم انقر على التالي.

- حدد تحميل مواقع الويب لبدء الإجراء، وأدخل عنوان URL الخاص بكل موقع ويب في مربع عناوين الويب، واحد في كل سطر. يمكنك أيضًا حفظ عنوان URL في ملف TXT واستيراده. يكون هذا مفيدًا إذا قمت بإعادة تحميل نفس موقع الويب لاحقًا. ثم انقر فوق التالي.

- اضبط الإعدادات حسب الرغبة وانقر فوق “إنهاء”.

بمجرد تحميل كل شيء، يمكنك تصفح موقع الويب بشكل طبيعي عن طريق الانتقال إلى المكان الذي قمت بتحميل الملفات فيه وفتح Index.html أو Index.htm في متصفح الويب الخاص بك.

طريقة استخدام HTTrack على ليتكس

بالنسبة لمستخدمي Ubuntu، إليك طريقة حفظ موقع ويب بأكمله باستخدام HTTrack.

- قم بتشغيل Terminal وأدخل الأمر التالي:

sudo apt-get install httrack

- سيُطلب منك كلمة مرور Ubuntu (إذا قمت بتثبيت كلمة مرور Ubuntu). اكتب واضغط على Enter. ستقوم المحطة بتحميل الأداة في غضون دقائق.

- أخيرًا، اكتب هذا الأمر واضغط على Enter. في هذا المثال، قمنا بتحميل موقع ويب “مقتطفات الدماغ” الشهير.

httrack https://www.brainpickings.org/

- سيؤدي هذا إلى تحميل موقع الويب بالكامل لقراءته في وضع عدم الاتصال.

يمكنك استبدال عنوان URL لموقع الويب هنا بعنوان URL الخاص بالموقع الذي تريد التحميل منه. على سبيل المثال، إذا كنت تريد تحميل Encyclopedia Britannica بالكامل، يجب عليك تغيير الأمر إلى:

httrack https://www.britannica.com/

تحميل: HTTPrack لنظام التشغيل ويندوز | ليتكس | أندرويد (مجانًا)

أفضل 7 مواقع آمنة لتحميل APK لنظام أندرويد

4- برنامج SiteSucker لتحميل موقع ويب كامل

إذا كنت تستخدم جهاز الماك، فإن SiteSucker هو أفضل رهان لك. يقوم هذا التطبيق البسيط بنسخ موقع ويب بأكمله، مع الاحتفاظ بنفس البنية ويتضمن جميع الوسائط ذات الصلة (الصور وملفات PDF وأوراق الأنماط وما إلى ذلك).

كما يحتوي على واجهة نظيفة وسهلة الاستخدام. يمكنك حرفيًا لصق عنوان URL لموقع الويب والضغط على Enter.

كما تتمثل إحدى ميزاته الرائعة في القدرة على حفظ تقدم التحميل في ملف واستخدام هذا الملف لإعادة تحميل نفس الملف والهيكل إلى جهاز الاستقبال (أو أي جهاز آخر). تسمح هذه الميزة أيضًا لـ SiteSucker بإيقاف التحميلات مؤقتًا واستئنافها.

تكلف SiteSucker حوالي 5 دولارات وليس لديها نسخة مجانية أو نسخة تجريبية مجانية. هذا هو العيب الأكبر. يتطلب أحدث إصدار نظام الماكOS 11 Big Sur أو أحدث. ستعمل الإصدارات الأقدم من SiteSucker على أنظمة الماك القديمة، ولكن قد لا تتوفر بعض الميزات.

تحميل: SiteSucker لنظام آي أو إس | الماك (4.99 دولارًا)

5- موقع Wget

Wget هي أداة مساعدة لسطر الأوامر يمكنها استرداد جميع أنواع الملفات عبر بروتوكولات HTTP و FTP. يتم تقديم مواقع الويب عبر HTTP ويمكن الوصول إلى معظم ملفات وسائط الويب عبر HTTP أو FTP، مما يجعل Wget أداة رائعة لتحميل مواقع الويب بالكامل.

يأتي Wget مرفقًا بمعظم الأنظمة التي تستند إلى Unix. يستخدم Wget عادةً لتحميل الملفات الفردية، ولكن يمكن استخدامه أيضًا لتحميل جميع الصفحات والملفات الموجودة في الصفحة الأولية بشكل متكرر.

wget -r -p https://www.domain.com

اعتمادًا على حجمه، قد يستغرق تحميل الموقع بالكامل بعض الوقت.

ومع ذلك، فإن نسخ موقع ويب يمكن أن يستهلك قدرًا كبيرًا من النطاق الترددي، لذلك قد تكتشف بعض مواقع الويب نيتك وتحظرها. للتغلب على هذا، يمكنك استخدام سلسلة وكيل المستخدم لانتحال شخصية متصفح الويب:

wget -r -p -U Mozilla https://www.domain.com

إذا كنت تريد أن تكون مهذبًا، فيجب عليك أيضًا تحديد سرعة التحميل حتى لا تستخدم النطاق الترددي لخادم الويب الخاص بك. يمكنك أيضًا التوقف مؤقتًا بعد كل تحميل لتجنب التحميل الزائد على خادم الويب بطلبات كثيرة. استخدم الأمر:

wget -r -p -U Mozilla — wait=10 — limit-rate=35K https://www.domain.com

طريقة استخدام Wget على نظام الماك

على نظام الماك، يمكنك تثبيت Wget باستخدام أمر Homebrew واحد:

brew install wget

إذا لم يكن لديك برنامج Homebrew مثبتًا بالفعل، فقم بتحميله باستخدام الأمر التالي:

/usr/bin/ruby -e “$(curl -fsSL https://raw.githubusercontent.com/Homebrew/install/master/install)"

ثم قم بتثبيت Wget باستخدام الأمر التالي:

brew install wget

بمجرد تثبيت Wget، يمكنك تحميل موقع الويب باستخدام الأمر التالي:

wget path/to/local.copy http://www.domain.org/

في ويندوز، يجب عليك استخدام هذا المنفذ. قم بتحميل التطبيق وتثبيته واتبع التعليمات الموجودة على موقع الويب لإكمال التحميل.